Grafiken oder Illustrationen auf Knopfdruck erstellen – eine entlastende Vorstellung für Kulturakteur:innen mit vollen Schreibtischen und knappen Budgets. Hier erfahrt ihr, was KI-Bildgeneratoren können, wo es hakt und wie ihr zu den bestmöglichen Ergebnissen gelangt.

Barock gekleidete, menschenähnliche, teils kopflose Figuren in einer Szenerie, die Science-Fiction-Assoziationen weckt: Das Bild „Théâtre D’Opéra Spatial“ des Künstlers Jason Allen ist ein Hingucker. Das fanden auch die Juror:innen der Colorado State Fair und verliehen dem Werk im Juni 2022 den ersten Preis in der Kategorie „Digital Arts/Digitally Manipulated Photography“. Was ihnen nicht klar war: Der erste Entwurf für das Bild stammte nicht vom Künstler selbst, sondern vom KI-Bildgenerator Midjourney.

Was ihr über Bild-KIs wissen solltet

Midjourney & Co. können heute noch viel mehr als damals. Dabei hat sich an der Technik in den vergangenen Jahren wenig geändert. Vor allem leistungsfähigere Rechner und große Massen an Trainingsdaten sind verantwortlich dafür, dass die ausgegebenen Bilder heute so beeindruckend sind.

Das Potential und die Funktionsweise von Bild-KIs lösen seit einigen Jahren Diskussionen aus: über das Wesen von Kunst, über Urheberrecht und den Umgang mit Deep Fakes. Im Zentrum der Diskussion stehen die Datensets, die zum Training der Tools eingesetzt werden und aus denen diese ihre Bildwelten schöpfen.

Im zweiten Teil unserer Workshop-Reihe „KI trifft Kultur“ war die KI-Agentur Birds on Mars mit viel Input und praktischen Übungen bei uns zu Gast, um die Arbeitsweise KI-gestützter Bild-Tools kritisch einzuordnen und ihre Möglichkeiten für den Kulturalltag zu erkunden.

Die Rechercheergebnisse und Tipps der Birds on Mars bilden auch die Basis für diesen Text. Vielen Dank, dass wir sie in dieser Form weiterverwenden dürfen!

In ihrem ersten Vortrag erklärte Tabea Glindemann, wie KI-Bildmodelle funktionieren, was man über die Datengrundlage weiß (und was nicht) und was einige der populären Anbieter:innen auszeichnet. Die Aufzeichnung des Vortrags findet ihr hier zum Nachschauen:

Das Wichtigste in Kürze

Kreative Roboter – oder alles nur geklaut?

Die Datenbasis vieler Bild-Tools enthält mutmaßlich viele bekannte und weniger bekannte Kunstwerke und künstlerische Erzeugnisse – ohne dies zu kennzeichnen oder das Einverständnis von Künstler:innen und Rechteinhaber:innen einzuholen.

Wie sich dieser Umstand auf die Rechte der Endnutzer:innen an den von ihnen generierten Bildern auswirkt, ist Gegenstand aktueller Debatten. Eine rechtssichere Auskunft zur Nutzung KI-generierter Bilder im Kulturalltag bietet dieser Artikel deshalb nicht.

Wer solche Bilder dennoch öffentlich nutzen möchte, sollte sich zumindest anbieterseitig in Sicherheit bringen. Lest in den Nutzungsbedingungen nach, welche Rechte die Anbieter:innen euch und sich selbst an den von euch generierten Bildern einräumen und unter welchen Bedingungen ihr die generierten Bilder auch kommerziell nutzen dürft.

Bild-Tools können Stereotypen verstärken

Im Durchschnitt enthalten die Trainingsdaten sehr viel Bildmaterial über westliche Gesellschaften und über (vermeintlich) westliche Menschen. Auch dieses Bildmaterial ist (beispielsweise durch die Überrepräsentation weißer Menschen auf Stockfotos) aber alles andere als ausgewogen. Über andere Teile der Welt gibt es dann in den Datensätzen deutlich weniger und deutlich undifferenzierteres Bildmaterial.

Außerdem sind die Tools darauf programmiert, Bilder auszuwerfen, die mit einer hohen Wahrscheinlichkeit den vermeintlichen Vorstellungen der Nutzer:innen entsprechen – was den Effekt zusätzlich verstärkt. Statt einer prozentual richtigen Ausgabe von 25 % weiblichen Vertreterinnen eines bestimmten Berufsfeldes, würden sie also dazu tendieren, die männliche Variante auszuspielen.

Die Anbieterfirmen reagieren auf dieses Problem, das auch ihr Image schädigt, indem sie die Systemeinstellungen der Programme nach und nach in Richtung eines diverseren Outputs lenken. Ein Beispiel: Hier findet ihr den System-Prompt, also die Basiseinstellung von DALL·E 3.

Auch diese Lösungen haben aber ihre Tücken. So warf Googles offenbar auf Diversität gepoltes Gemini-Tool Bilder weiblicher oder schwarzer Wehrmachts-Soldat:innen aus. Das IT-Magazin The Verge hat diesem Problem einen Artikel gewidmet: Google apologizes for ‘missing the mark’ after Gemini generated racially diverse Nazis.

Auch dieses Problem ist mittlerweile gefixt. Es zeigt aber, dass ihr gerade in heiklen Kontexten genau hinschauen solltet, bevor ihr ein KI-generiertes Bild für eure Arbeit nutzt.

Bild-KIs lernen mehr konkret als abstrakt

Wenn ihr ein Bild-Tool beauftragt, ein Pferd zu zeichnen, wird dieses Pferd höchstwahrscheinlich vier Beine und einen Kopf haben. Dass ihnen das gelingt, liegt aber nicht daran, dass sie das abstrakte Konzept „Pferd“ kennen und wissen, dass Pferde (normalerweise) mit dieser Anzahl Körperteile ausgestattet sind. Sie orientieren sich vielmehr an der Wahrscheinlichkeit bestimmter Bildpunkte in Milliarden von Bildern, die in ihren Trainingsdaten mit dem Wort „Pferd“ verknüpft sind. Weil auf diesen Bildern aber nicht immer alle Körperteile des Pferdes zu sehen sind oder auf der Koppel hinter dem ersten noch ein zweites Pferd steht, kann es passieren, dass auf den ausgegebenen Bildern ein Körperteil mehr oder weniger vorkommt.

Korrekte Texte: Fehlanzeige

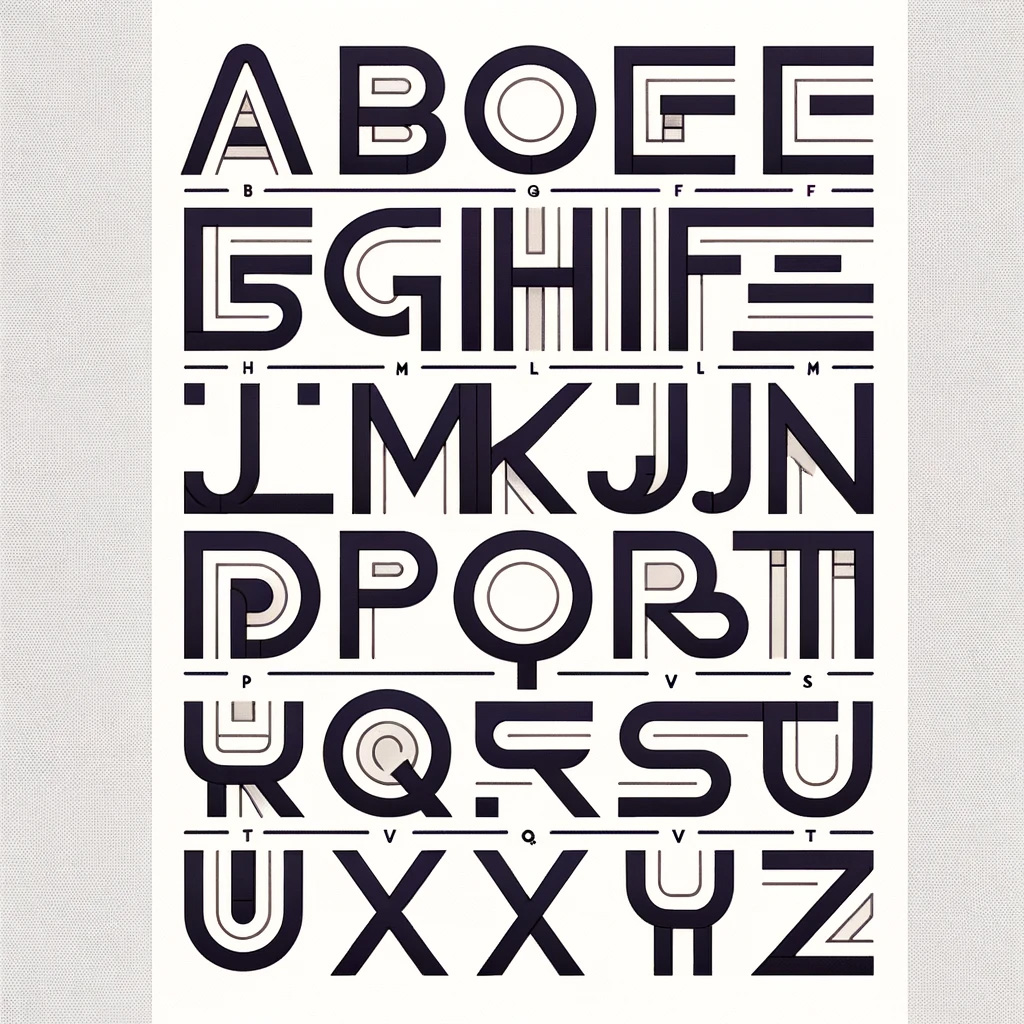

Wenn man sie beauftragt, Text darzustellen, „erfinden“ sie meist zusätzliche, typographisch anmutende Bausteine und Fantasiebuchstaben. Wenn ihr beispielsweise Grafiken für Veranstaltungseinladungen generieren wollt, fügt den Text also besser nachträglich mit einem Grafikprogramm ein.

„Hey DALL·E, zeige mir das Alphabet von A bis Z gut lesbar auf einem schlichten Plakat.“

Was ist Outpainting?

Outpainting bezeichnet die Erweiterung eines Bildes im selben Stil und mit passenden Inhalten über den ursprünglichen Bildrand hinaus. Ein Beispiel könnte das Bild eines einzelnen Pferdes auf einer Koppel sein, das um weitere Pferde und den angrenzenden Bauernhof erweitert wird.

Was ist Inpainting?

Inpainting bezeichnet die Veränderung einzelner Anteile innerhalb eines Bildes. Die Funktion ist Teil vieler Bild-KIs und funktioniert bei neu generierten Bildern schon ziemlich gut. Ob und wie sie auch für die Rekonstruktion fragmentiert erhaltener Kunst eingesetzt werden sollte, wird aktuell beforscht.

Die Idee: KIs können auf der Basis besser erhaltener Kunstwerke aus der gleichen Epoche / von den gleichen Künstler:innen Vorschläge machen, wie das fragmentierte Bild ursprünglich ausgesehen haben könnte. Ein potenzieller Nachteil: Kunst, die aus unterschiedlichen Gründen (Zensur, mutwillige Zerstörung o.ä.) nicht oder schlechter erhalten wurde, erfährt durch diese Begünstigung der nicht-zensierten Kunst eine nachträgliche und zusätzliche Benachteiligung.

Hier findet ihr ein Paper der Internationalen Gesellschaft für Photogrammetrie und Fernerkundung: The Role of Artificial Intelligence and Machine Learning in preserving Cultural Heritage and Art Works via Virtual Restoration

Was ist Upscaling?

Upscaling bezeichnet die Vergrößerung der Tiefenschärfe, Creative Upscaling die Vergrößerung des Detailreichtums eines generierten Bildes.

Weiterführendes zu Biases bei Bildtools

Ihr wollt noch mehr Input zu Biases bei KI-Tools und den Möglichkeiten, ihnen entgegenzuwirken? Dann schaut euch auch das Video zu Tabea Glindemanns zweitem Vortrag von unserer Veranstaltung im März 2024 an.

Einen Long-Read zum Thema mit illustrativer Bildstrecke von der Washington Post findet ihr hier: This is how AI image generators see the world.

Zum Thema Biases gegenüber Menschen mit Behinderung hat das Magazin Die neue Norm recherchiert: Wie künstliche Intelligenzen Behinderung interpretieren – oder auch nicht.

Ob Bilder von euch oder eurer Organisation in großen Trainingsdatensätzen vorkommen, könnt ihr bei Have I Been Trained überprüfen – und für die zukünftige Verwendung eurer Bilder ein Opt-Out hinterlegen: https://haveibeentrained.com/

3 Tools kurz vorgestellt

Auf Basis der Infos aus unserer Veranstaltung mit den Birds on Mars haben wir Eigenschaften zu einigen populären Bild-Tools bzw. Modelle, die vielen Tools zugrundeliegen, zusammengetragen. Sie können euch helfen, euch für ein Tool zu entscheiden, mit dem ihr ans Ausprobieren geht.

| Playground AI | DALL·E 3 | Adobe Firefly | |

|---|---|---|---|

| Voraussetzungen | für die Nutzung benötigt ihr ein Google-Konto | OpenAI-Account erlaubt Zugriff via ChatGPT4 und Programmier-Schnittstelle (API); Modell ist Basis vieler weiterer Systeme, für die meist ein Account nötig ist | Integriert in Photoshop, Illustrator, Adobe Express und Adobe Stock plus Webversion |

| Kostenlos nutzbar? | Ja, wird aber schnell langsamer und fordert zur Einrichtung eines Bezahlaccounts auf. | Abhängig von jeweiligem Tool / Zugangsart | Nein |

| Funktionen und Interface | – mit Inpainting, Outpainting und Creative Upscaling – Board-Modus zum Erstellen einzelner Bilder; Canvas Modus: Bilder lassen sich verändern oder im selben Stil über den Bildrand erweitern. – bietet Zugriff auf die Modelle Playground v2 & v2.5, Stable Diffusion XL. | – Inpainting seit kurzem verfügbar; – Bei Einbindung über API hat DALL·E ein eigenes Interface mit diversen Features. – Bei Nutzung über ChatGPT4 bleibt DALL·E eher eine Blackbox. | Viele Funktionen: klassisches Text-zu-Bild, Inpainting, Outpainting, Texteffekte, einfärben, Vektorgrafiken. |

| Bilder öffentlich einsehbar? | Generierte Bilder werden in öffentliche Galerien hochgeladen. | Mit ChatGPT bleiben die generierten Bilder privat – werden aber nur für einen bestimmten Zeitraum gespeichert | Generiert Bilder lokal, überträgt sie also nicht automatisch auf Adobe-Server |

| Herkunft der Trainingsdaten | Keine näheren Infos. | Keine näheren Infos. | Wirbt damit, für das Training keine Bilder ohne Erlaubnis genutzt zu haben (gemeinfreie sowie lizenzierte Bilder von Adobe Stock) |

| Zusatzinfos | Bei YouTube gibt es eine Anleitung für die verschiedenen Funktionen. | Für einen Blick hinter die Kulissen, klickt auf das generierte Bild und dann im rechten oberen Bildrand auf das Info-Symbol. Dort seht ihr, welchen Prompt das Programm aus euren Vorgaben in der Chat-Zeile gemacht hat, um das Bild zu generieren. | Adobe setzt sich mit einem Transparenz-Symbol für eine Kennzeichnung KI-generierter Inhalte ein. Mehr dazu in diesem Golem-Artikel. |

Tipps für bessere Prompts – und bessere Ergebnisse

Die gleiche Aufgabe mit dem gleichen Ergebnis zu beantworten, ist eines der entscheidenden Merkmale von funktionierender Software – normalerweise. Generative KI-Tools funktionieren anders. Zu ihren zentralen Fähigkeiten gehört es, unterschiedliche Vorschläge für die Erledigung derselben (kreativen) Aufgabenstellung zu machen. Erwartet von den Ergebnissen eurer ersten Prompts also nicht zu viel , sondern tastet euch iterativ an das gewünschte Ergebnis heran. Hier ein paar Dinge, die ihr dabei beachten könnt:

- Auf Englisch prompten. Bild-Tools werden mit einer Kombination aus Bildern und Bildbeschreibungen aus dem Internet trainiert – und letztere sind oft auf Englisch. Englischsprachige Prompts liefern daher oft die besten Ergebnisse.

- Aufgaben präzise formulieren. Je genauer ihr selbst wisst, was ihr wollt, desto besser sind eure Chancen, es auch zu bekommen. Gebt dem Bildgenerator möglichst spezifische Informationen zum Inhalt, zum Medium (Foto, Gemälde, Illustration, Skulptur…), zur Umgebung (draußen, drinnen, unter Wasser, im Wald), zu den Lichtverhältnissen, den Farben, der Stimmung und der Komposition (Vogelperspektive, Porträt, …) des Bildes.

- Das Tool promptet mit. Zur Verbesserung der Ergebnisse ergänzen die Tools die von euch eingegebenen Prompts oft um Bilddimensionen, die euer Prompt nicht abgedeckt hat. Was das Tool hinzugefügt hat, könnt ihr meist in den Zusatzinformationen zum generierten Bild erfahren.

- Stil- und Genrevorgaben nutzen. Sie haben einen starken Effekt aufs Ergebnis. Beispiel: „Erzeuge mir ein Bild im Stil des Impressionismus / Kubismus / Cyberpunk…“

- Je konkreter, desto besser. Statt beispielsweise um ein Bild zu bitten, das die digitale Entwicklung im Kultursektor veranschaulicht, fragt lieber nach einem Foto, das eine Gruppe Menschen bei einem AR-gestützten Audiowalk durch Berlin im Sommer zeigt. Als ergänzende atmosphärische Information könnt ihr dem Tool dann aber mitgeben: „Das Foto veranschaulicht die Ergänzung analoger Kulturvermittlung durch digitale Tools.“

- Problemfeld Diversität. Wie bekomme ich ein Tool, das mit Vorurteilen und Hochglanz-Stockfotos weißer, able-bodied Menschen gefüttert wurde dazu, mir wirklich diverses und dabei nicht klischeetriefendes Bildmaterial zu liefern? Ein Versuch sind solche Prompts, die möglichst explizit werden: „A photorealistic image of a diverse group of people representing different ethnicities, including Black, Indigenous and Caucasian.“ Aber Vorsicht: Macht euch bewusst, dass ihr so auch Zuschreibungen von ethnischer und nationaler Herkunft adressiert und Klischees reproduziert – bei oft dennoch nicht besonders überzeugenden Ergebnissen. Überlegt in solchen Fällen, ob echte Fotos echter Menschen nicht die bessere Wahl sind.

- Bedienungsanleitungen lesen. Einige Herstellerfirmen von Bild-KIs stellen Bedienungsanleitungen („Dokumentationen“) für ihre Tools bereit. Dort erfahrt ihr, welche Informationen ein Programm braucht, um zufriedenstellende Ergebnisse zu produzieren. Die Bedienungsanleitungen ähneln sich stark, mit den Regeln aus der Midjourney-Dokumentation beispielsweise lassen sich auch bei anderen Tools gute Ergebnisse erzielen. Hier geht’s zur Midjourney-Dokumentation.

- Datenbanken zur Inspiration nutzen. Um sich von erfolgreichen Prompts anderer anregen zu lassen, kann man Anbieter:innen-Datenbanken durchstöbern, in denen KI-generierte Bilder mit den zugehörigen Prompts abgebildet sind. Eine große Datenbank ist jene des Bildgenerator lexica, zu finden unter lexica.art, auch bei Midjourney findet man viele Beispiele: midjourney.com/explore

- Schlichte Bilder sind schwierig. Eine der am schwersten umzusetzenden Aufgaben für Bild-Tools: Imitationen schlechter Fotos. Die bekanntesten Tools sind allesamt darauf trainiert, Hochglanzbilder zu liefern, die von innen zu strahlen scheinen. Eine Parallele zu ChatGPT, dessen Texte oft werbend wirken und floskeldurchsetzt sind. Wer es schlichter mag, muss dem mit gezielten Prompts entgegenwirken.

- Transparenz schafft Vertrauen. Wenn ihr KI-generierte Bilder öffentlich nutzt, solltet ihr das in der Bildunterschrift kenntlich machen. Das verlangt (mit Ausnahmen, beispielsweise für Kunstwerke) nicht nur der EU AI Act, der im März 2024 vom EU-Parlament mit großer Mehrheit angenommen wurde und ab Juni 2024 schrittweise in Kraft treten soll. Es stärkt auch das Vertrauen eurer Zielgruppe – und macht es ihr möglich zu erkennen, wo sie im Alltag schon KI-generierten Inhalten begegnet.

Text: Thorsten Baulig